Jean Claude Heudin a été le directeur du laboratoire mon école supérieur, l’institut Internet et du multimédia pendant des années, c’est un ami, un mentor qui nous a donné les bonnes méthodes d’apprentissage et ses mots clés. Diplômé d’un doctorat en Intelligence artificielle à ORSAY, université de Paris Sud, il a été habilité à faire des recherches pour l’armée et a travaillé dans de nombreux domaines de pointes comme l’architecture du processeur RISC, les algorithmes génétiques ou bio-inspirés et l’intelligence artificielle plus généralement.

J’ai décidé à travers cet article de vous faire part d’un de ses derniers livres intitulé : « Intelligence Artificielle : manuel de survie » dans une synthèse non exhaustive détaillant d’abord les principaux axes de recherches de l’IA, ses différentes formes, les peurs qui y sont liées, les idées reçues, et un dernier point sera fait sur l’éthique. Je me suis aussi inspiré de ce que j’ai lu dans un autre de ses livres intitulé « Immortalité Numérique »

Je vous recommande vivement d’acheter ces livres qui sont à mon sens des trésors de connaissance, de réflexion et de travail.

Les 17 axes de recherches de l’IA

- Les systèmes multi-agent.

Champ de domaine capital en Intelligence Artificielle, le concept a été inventé par Marvin Minsky de l’université de Stanford. Les systèmes multi-agents se sont tellement développés au cours des dernières décennies qu’ils sont devenus incontournables.

Les systèmes multi-agent font partie de ce qu’on appelle l’intelligence artificielle distribuée, le but d’un système multi-agent est par exemple de fractionner un calcul complexe en série de petits calculs que la machine sera mieux à même de traiter. On peut appeler cela en Informatique le parallélisme massif par exemple : effectuer des tâches de calculs sur un nombre important d’ordinateurs connectés entre eux. (réseau)

En Informatique chaque agent est donc un petit programme exécutant un certain nombre de tâches qui s’inscrit dans une structure hiérarchisée. Je définirais à l’aide d’un autre livre de Jean-Claude (Immortalité numérique) l’ensemble de ces structures.

Définition de l’agent : L’agent peut-être de différentes formes, on peut parler de petits programmes implémentés dans un logiciel, d’animaux au sein d’un groupe, de personnes physiques.

Deux grandes catégories : les agents réactifs et les agents cognitifs.

Les agents réactifs sont des agents comportementalistes ou « behavioristes » qui vont se contenter de subir leur environnement par exemple selon le fameux modèle SIR :

- Stimulation de l’environnement

- Individu

- Réaction par rapport au stimulus

Plus précisément dans un système Informatique ils ont une fonction réflexe c’est à dire qui des programmes qui réagissent immédiatement à des informations reçues en entrée.

Les agents cognitifs quant à eux vont influer sur leur environnement, ils passent à l’action, ils sont capables de prise de décision.

On distingue parmi ces agents les nèmes qui stockent des connaissances qu’on pourrait qualifier d’agents réactifs, des nomes qui sont capables de traiter ces connaissances qui sont donc des agents cognitifs. Parmi ceux là : Les polynèmes sont capables d’activer des agents représentant différents aspects d’un même objets tandis que les paranomes sont capables de traiter simultanément différents représentations de connaissances.

Ces agents spécialisés sont accompagnés d’agents gestionnaires chargés de planifier et d’organiser. Tous ces agents se structurent alors pour former des tableaux (frame-array) qui sont capables d’exécuter des calculs complexes. Quels sont alors les différents modes d’organisation hiérarchiques de ces structures ? :

On compte 9 typologies :

- Hiérarchie

La hiérarchie se structure sous la forme d’un arbre avec des nœuds représentés par l’agent qui possède une autorité sur un noeud-fils.

- Holarchie

La holarchie est une hiérarchie sans autorité, les agents sont inclus comme si on greffait des feuilles à l’arbre.

- Coalition

La coalition est une alliance temporaire dont la valeur de l’objectif doit être supérieur à la somme des agents qui la composent

- Équipes

Les équipes ont pour but de maximiser les intérêts de l’équipe dans un objectif commun à tous les agents.

- Congrégations

Les congrégations sont voisines des équipes et des coalitions sauf que les agents peuvent sortir ou rentrer dans la congrégation. Il n’y a aucune permanence.

- Sociétés

Les sociétés sont des ensembles d’agents hétérogènes de nature différentes mais soumis à des lois communes

- Fédérations

Les fédérations sont des entités qui laissent place à un système de délégations ou les interactions se font entre délégués des agents.

- Marchés

Les marchés sont un système d’agents vendeurs et acheteurs qui permettent de définir des stratégies de négociation.

- Matrices

Les matrices sont des agents interconnectés (lignes et colonnes) et interdépendants entre eux.

Ces typologies dans un système multi-agent peuvent s’associer entre-elles, on peut par exemple avoir des fédérations de sociétés d’agents.

Passons aux champs suivants que je développerai moins :

- La perception et la vision par ordinateur sont les systèmes de reconnaissance faciales mis en place par nos caméras installés sur nos smartphones ou ordinateurs.

Par exemple Face ID cherche à enregistrer numériquement l’empreinte mathématique de votre visage à des fins biométriques de sécurisation. Ces applications utilisent des réseaux de neurones convolutifs qui simulent notre cortex visuel.

- L’apprentissage machine aussi appelé machine learning (ML) compte 3 types d’apprentissage : supervisé, non supervisé, ou par renforcement (système de récompense). Derrière le terme d’apprentissage machine assez généraliste se cachent d’autres algorithmes qui ont connu un grand essor ces dernières années tels que les réseaux de neurones profonds (deep-learning) ou les algorithmes évolutionnaires.

- Les algorithmes évolutionnaires s’inspirent des théories de l’évolution biologique, ils comprennent par exemple les algorithmes génétiques (néo-darwinisme voir John Holland) et ses fonctions d’évaluation dites « fitness ». Une fonction fitness est par exemple une fonction destinée à évaluer les personnes les plus aptes à faire évoluer ou avancer l’humanité. Rien à voir avec la programmation génétique qui est un outil d’optimisation de la performance d’une chaîne de programmes.(voir John Koza)

- Le connexionnisme qui est à la base du réseau de neurones comme vous l’avez peut-être vu sur mon article sur les sciences cognitives notamment la synapse de Hebb. Plus généralement le connexionnisme s’intéresse à tout ce qui peut être connecté pour maximiser les performances s’opposant à la centralisation des calculs par le processeur d’un ordinateur par exemple. Le parallélisme massif organisé en réseau est une forme de connexionnisme.

- L’intelligence affective est le domaine de recherche pour un ordinateur de percevoir, exprimer et ressentir des émotions. Le chatbot Eliza créé par Joseph Wieszenbaum était capable de percevoir et d’exprimer des émotions mathématiquement mais le ressenti est encore hors de portée, en effet la machine ne dispose d’aucune fonctions physiologiques.

- L’intelligence collective s’intéresse par exemple à l’organisation en groupe d’un ensemble d’individus ou pourquoi pas d’agents qui interagissent ensemble dans un but commun, par exemple dans la nature, une colonie de fourmis qui œuvrent toutes ensemble pour le bien de la fourmilière.

- La résolution de problèmes et de raisonnements est la base du domaine de recherche de l’intelligence artificielle. Le but étant de simuler le raisonnement humain par exemple lors d’un syllogisme ou d’une inférence. Le principal problème de ce champ de recherche est l’explosion combinatoire qui peut être occasionnée de par la multiplicité de variables ou de fonctions à calculer. On va donc chercher à palier à ce problème par de la recherche heuristique c’est à dire en filtrant les paramètres de sortie et en excluant certaines solutions.

- Traitement symbolique et logique représente également un des premiers champs de recherche de l’IA. Le symbolisme par opposition au raisonnement quantitatifs (variables binaires) permet de calculer par association d’objets catégories ou concepts. Deux langages ont été créé à ces fins : Prolog par Alain Colmerauer et Philippe Roussel deux informaticiens français et Lisp pour traitement par liste crée par John McCarthy(1958)

- Le langage naturel ou NLP s’intéresse à la compréhension par l’ordinateur des chaînes de caractères que forment notre alphabet qui peut se décliner en mots, en phrase, et en texte. Fortement lié à la linguistique et ses branches comme la sémantique, l’orthographe, la grammaire, la traduction automatique dans différentes langues (analyse de récurrences) sont des domaines du traitement naturel du langage.

- La planification est l’étude de principes organisationnels visant à réduire les coûts, et optimiser les durées de travail par exemple pour agir en temps réel afin de réaliser un objectif de manière optimale pour un robot ou un agent (prise de décision).

- La robotique est intimement lié à l’IA, dès qu’il s’agit d’implémenter à un robot un fonctionnement intelligent ou un système de perception l’IA représente une passerelle obligatoire. La robotique est donc un terrain d’expérimentation privilégiée de l’IA.

- Les réseaux de neurones ont vu le jour dès la création de la discipline cybernétique dont j’ai déjà parlé dans mon article sur les sciences cognitives. Mais les réseaux de neurones profonds changent aujourd’hui la donne tant les avancées sont significatives durant les dernières années : On distingue les réseaux simple-couche, multi-couche (couches cachées, couches visibles) , récurrents (qui bouclent sur eux même), non récurrents, convolutifs (traitement de l’image). Supervisés, (main de l’homme dans l’apprentissage), à priori non supervisés (réseau par adversaire, voir Ian Goodfellow) ou encore par renforcement. (système de récompenses).

- La vie artificielle aussi appelée A-life, représente l’étude du vivant et de son comportement dans un environnement artificiel tel que l’ordinateur.

- Les systèmes à base de connaissance est une des formes de l’IA regroupés sous le champ de recherche des systèmes experts très utilisés en médecine dans les années 1980. Un des plus connus fut Mycin développé par Edouard Shortliffe qui permettait de diagnostiquer et traiter les leucémies grâce à un système de base de connaissance basé sur des faits, des règles et un moteur d’inférence. Une inférence peut-être déductive (syllogisme), abductive (élimine les solutions improbables) inductive(basé sur l’observation factuelle)

- Les représentations de connaissances est la mise en forme pour une IA d’un ensemble d’objets, de données, d’informations sur un problème pour aider l’algorithme à calculer de manière efficace. On parle alors d’ontologie complètes ou spécifiques représentés sous forme de graphiques.

- La logique floue conceptualisée par Lofti Zadeh part de variables réelles plutôt que binaires, une information peut-être vrai et fausse. Plus exactement, une information vraie à un moment donné peut-être fausse l’instant d’après.

Les 6 formes de l’IA

- L’intelligence inférieur à un humain pour une tâche spécifique

- L’intelligence égale à un humain pour une tâche spécifique

- L’intelligence supérieure à un humain pour une tâche spécifique

- L’intelligence supérieure à un humain pour une multiplicité de tâches

- L’intelligence supérieure à tous les humains pour une multiplicité de tâches on parle alors d’AIG pour Intelligence Artificielle Générale

- La singularité technologique représente une prise de contrôle de l’humanité par une intelligence artificielle.

On peut faire une césure entre les quatre premières formes d’IA qui sont regroupés sous la forme d’une IA Faible alors que les 2 dernières 5 et 6 font parties des IA Fortes. Aujourd’hui on recherche particulièrement à développer ces deux dernières formes.

Les Peurs liées à l’IA

1.La singularité technologique

La singularité est technologique, j’en ai déjà parlé dans le premier article du site sur la super-intelligence. C’est l’avènement d’une IA qui s’imposera comme un singleton et qui contrôlera l’humanité. Plus encore Kurzweil décrit la singularité technologique comme l’avènement d’une super-intelligence en 2045 dont le fonctionnement nous paraîtra impossible à comprendre et qui pourra créer des machines également plus intelligentes que notre cerveau.

La première conséquence positive défendue par le transhumaniste Ray Kurzweil part du principe que les hommes seront augmentés, que les maladies incurables seront guéries et que l’IA sera bienveillante.

La deuxième conséquence dite pessimiste : pour Stephen Hawking et Elon Musk, part du principe que l’IA sera inamicale et qu’elle décidera par exemple pour sauver la planète si c’est réellement son but et par extension de se débarrasser de l’humanité le considérant comme un danger pour celle-ci.

Pour Nick Bostrom dont j’ai déjà parlé dans mon premier article l’IA, celle-ci raisonnera par l’orthogonalité (une fonction de deux variables en x et y) par volonté et intelligence, elle choisirait toujours la solution la plus simple.

2. Le spectre des armes autonomes

Il existe quelques exemples d’armes autonomes en voie de développement par différents pays : RoBattle, ou l’IA antiaérienne Alpha en fait partie, et la course à l’armement est déjà engagée. C’est contraire à un des 23 principes d’Asilomar qui veut que l’on évite d’utiliser l’IA pour développer des armes létales, cependant on trouvera toujours des partisans au développement de la robotisation armée ne serait-ce que pour éviter des pertes humaines.

3. L’IA va détruire l’emploi

L’intelligence Artificielle ne détruira pas l’emploi, au contraire elle visera à créer des emplois hautement qualifiés pour être conçue et appliquée et permettra à la société d’arrêter l’exploitation des humains pour des tâches répétitives et sur le long terme contre productive pour notre esprit. Il est intéressant de noter que les pays robotisés sont les pays ou le taux de chômage est le plus bas.

4.Des boites noires

Les boîtes noires sont une crainte tout à fait avérée de l’IA, derrière le terme « boite noire » relatif à ces dispositifs aériens qui sont censés expliquer les causes d’un crash, se cache tout le fonctionnement opaque de l’algorithme. Aujourd’hui un des futurs de l’IA est l’XAI pour « explicable AI » lire le deuxième livre d’Aurélie Jean « Les algorithmes font-ils la loi ? ». La commission européenne a notamment déjà sommé les GAFAMI d’expliquer leurs algorithmes que ce soit un algorithme de recommandation dit explicite basé la plupart du temps sur des arbres de décisions ou un algorithme de neurones profonds dit implicite. Tout l’enjeu est d’auditer et comprendre le code pour tenter d’expliquer les résultats de l’IA et comprendre d’éventuels biais. (concept défini par Aurélie Jean dans son premier livre « Une fille au pays des algorithmes »)

5.IA sexistes et racistes :

On a déjà assisté à de nombreux biais sexistes et racistes de la part de l’IA, le premier biais sexiste fut l’algorithme d’Amazon qui discrimina les femmes à l’embauche ou bien celui de l’Apple Card dénoncé en personne par Steve Woszniak. Votre banque vous accorde un crédit immobilier déjà sur la base de paramètres algorithmisés. Aux États-Unis des biais ont notamment été constatés lors de la libération de détenus suite à une peine de prison pour éviter la récidive. « Voir Coded Bias » sur Netflix . Ces biais cognitifs sont implémentés par les concepteurs de l’algorithme dans leur logique programmatique ou dans le jeu de données sélectionnées pour entraîner l’IA. Il faut implémenter un mécanisme d’auto-régulation entre les ingénieurs à la conception de l’algorithme.

6.Les IA peuvent être détournées

Il est important de comprendre que le développement d’une IA super intelligente passe par le développement de la cyber-sécurité afin de limiter les piratages de ces IA d’une part, et d’autre part restreindre l’accès des IA omnipotentes à une personne légitime et éclairée et responsable.

7.Notre vie privée est violée

Le big data mis en place par les GAFAMI a été le socle pour que le développement d’une IA qui permette de mieux classer, analyser, trier les données qui sont présente sur le web. Les micros et caméras des smartphones sont partout et constamment en marche, ce n’est pas nouveau et rien n’empêche aujourd’hui une entreprise même dans toute cet océan d’information de mettre en place une IA qui permette l’analyse et la récupération de données ciblées.

Les 8 idées reçues sur l’IA

1.Les IA sont meilleures que les humains

A proprement parler les IA ne sont pas meilleurs que les humains, d’une part car ce sont les humains qui les codent et d’autre part parce que toutes les IA qui ont battu les humains par exemple aux échecs (Deep Blue basés sur des algorithmes min-max) ou dans le jeu de Go (Alpha go développé par l’IA DeepMind de google sont entraînés sur une base de données de parties humaines.

2. Les IA veulent nous remplacer

L’IA n’a pas de volonté propre, elle n’a pour but que la réalisation de l’objectif que le code lui a implémenté.

3. La courbe de l’IA est exponentielle

La loi de Moore qui veut que la croissance de la puissance des composants électroniques et autres semi-conducteurs obéit à une fonction exponentielle (puissance) dont l’ordonnée pour une variable x à 0 est égal à 1 est fausse car elle ne prend pas en compte les réalités géopolitiques, géo stratégiques et l’approvisionnement en matières premières nécessaires pour les produire. On a a notamment vu avec l’impact de la pandémie de COVID, la ruée sur les cartes graphiques pour le minage de cryptomonnaies et l’appauvrissement des ressources de notre planète terre que la réalité rattrape toujours les prévisions.

4. L’IA a des sentiments

L’IA n’a pas de sentiments, elle peut exprimer des émotions, percevoir des émotions notamment grâce aux grandes avancées des travaux de neurones profonds mais le champs de recherche concernant la sensation des émotions est encore complètement neuf Même si le projet Living Mona Lisa (Heudin 2015) faisait apparaître des émotions à la Joconde, c’était plus de l’ordre de la simulation.

5. L’IA est consciente

On distingue deux types de consciences, la conscience primaire qui mêle perception et mémoire : « Edelman » et la conscience supérieure qui naît avec la sémantique et les facultés de langage : « John Eccles ». Pour moi cette conscience supérieure naît avec l’émergence du libre arbitre. Les aires de la parole qui interviennent dans l’intervention de la mémoire de la linguistique interagissent avec les aires conceptuelles déjà existantes du cerveau. La conscience de soi est la caractéristique la plus fondamentale de l’espèce humaine pour Théo Dobzhansky . Aucune IA n’a cette conscience mais cela ne veut pas dire que dans le futur aucune machine avec une conscience ne pourra émerger. J.C Heudin suggère de nouvelles pistes illustrées par les travaux de Francisco Varela et d’algorithmes bio-inspirés pour des nouvelles machines basés par exemple sur l’autopoièse qui se définit par l’auto-reproduction des cellules similaires aux divisions telles que la méiose et mitose.

6. L’IA est autonome et apprend seule

L’apprentissage non-supervisé sur le papier nécessite quand même l’intervention d’ingénieurs et chercheurs hautement qualifiés. Même si une IA apprend effectivement de manière autonome, il faut encore lui donner le volume de données approprié pour qu’elle puisse apprendre. En quelques sorte il faut l’alimenter.

7. L’IA ne sera jamais créative

Un homme comme une intelligence artificielle base sa création sur un patrimoine informationnel ou un nombre de connaissances qu’il a reçu, emmagasiné et interprété. Dire qu’une IA ne sera jamais créative est faux. Même si le processus artistique est créatif, les réseaux de neurones profonds ont permis aux IA des avancées spectaculaire dans le domaine musicale et pictural ces dernières années.

8. L’IA est vivante

On peut tout simplement résumer cette partie par un syllogisme : tout ce qui a une conscience est vivant, une IA n’a pas de conscience, donc une IA n’est pas vivante.

L’éthique en IA :

En 2017 s’est tenu à Asilomar en Californie une conférence organisée par le Futur of Life Institute qui a abouti à la rédaction de 23 principes rédigés sous la forme d’une charte pour une IA éthique qui a obtenu un franc succès auprès de la communauté scientifique puisqu’elle a été très largement signée. Certains de ces principes sont redondants ou vont de pair mais intéressons nous à cette dimension éthique si chère au site.

Les 23 principes d’Asilomar :

1. Objectif de recherche

bénéfice Le premier principe suppose que l’objectif de recherche sur l’IA doit tendre vers le bénéfique.

2. Investissements

Le deuxième principe concerne les investissements liés à l’IA selon 3 points :

- Préservation des ressources Les ressources de la planète doivent être préservés

- Piratage Les IA doivent être sécurisées à l’extérieur et à l’intérieur du programme pour empêcher l’utilisation détournée de l’IA par un groupe dissident.

- Evolution du système juridique Il est impératif d’améliorer notre système juridique et notamment les relations entre scientifiques et décideurs politiques pour permettre une législation pro-active et non à rebours de la technologie.

3. Relation entre les scientifiques et les juridictions

Conglomérat de scientifiques et de législateurs.

4. Culture ou esprit de recherche

Les scientifiques qui travaillent à améliorer les IA doivent avoir une vraie culture de la recherche.

5. Prévention

Respecter les normes de sécurité

6. Sécurité

Éviter le piratage

7. Transparence

Pouvoir expliquer la causalité d’un choix discriminant ayant causé des dommages faits par un algorithme d’intelligence artificielle.

8. Transparence judiciaire

Superviser la prise de décision d’un système autonome par un humain afin de corroborer la décision dans le cadre d’une décision judiciaire.

9. Responsabilité

Les concepteurs et les Constructeurs doivent répondre de l’utilisation abusive de leur système et endossent la responsabilité morale.

10. Concordance des valeurs

Les systèmes d’intelligence artificielle doivent être en adéquation avec les valeurs du genre humain.

11. Valeurs humaines

Des droits fondamentaux tels que la liberté, la diversité culturelle, le droit et la dignité doivent être respectés.

12. Données personnelles

Les données des utilisateurs doivent rester sa propriété, chacun devrait pouvoir contrôler, gérer, et organiser ses données.

13. Liberté et vie privée

La vie privée devrait être préservée, la restriction de cette liberté réelle devrait être interdite.

14. Bénéfices partagées

Devrait bénéficier à autant de personnes que possible

15. Prospérité partagée

Préservation des ressources économiques

16. Contrôle humain

Décision d’une délégation dans le cadre de la réalisation d’objectifs fixés.

17. Anti-renversement

Pouvoirs accrédités à une personne qui contrôle les systèmes d’IA devraient bénéficier à la société sur un plan global, social et moral.

18. Course aux IA d’armement

La course aux armes autonomes létales devrait être évitée.

19. Alertes sur les capacités

Toute prévision par rapport aux capacités supérieures de l’IA devrait d’abord faire l’objet d’un consensus entre chercheurs.

20. Importance

Important changement de paradigme de la vie sur terre.

21. Risques

Prévision des risques en vue de minimiser leur impact.

22. Auto-développement

Contrôle de sécurité des IA qui se répliquent de manière autonome.

23. Bien commun

Les IA super-intelligentes ne devraient être crées que pour la réalisation du bien commun et conférés à des Etats ou à des organisations.

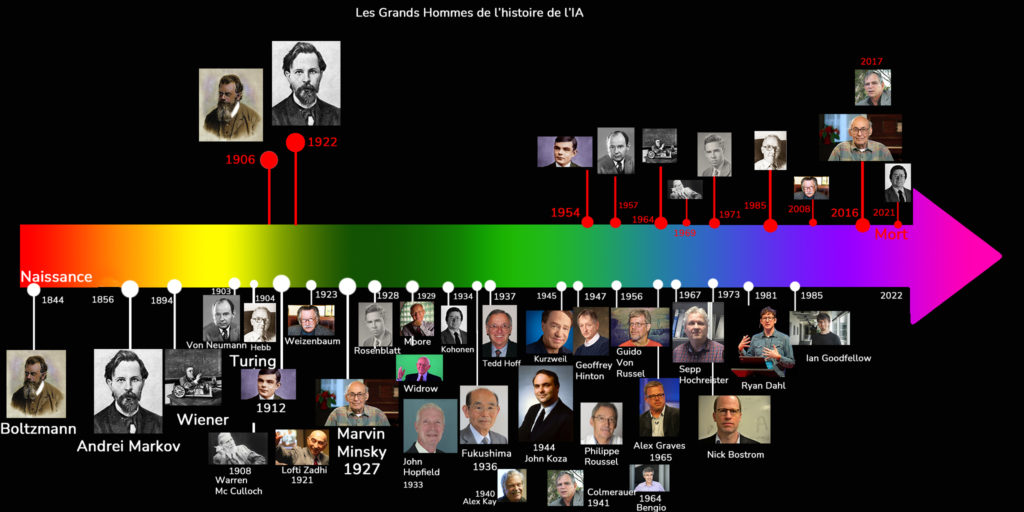

Pour terminer je vous ai dessiné une flèche du temps spectrale retraçant les naissances et morts des plus grands hommes de l’IA au cours des trois siècles derniers à partir du glossaire du livre : A mon sens c’est un bonne exercice pour travailler sa physionomie en fonction de ce qu’ont réalisé ces hommes. Je ne vous fais pas la liste exhaustive mais sachez que Boltzmann pour ne citer que lui est le père de la physique statistique et qu’il a donné son nom à certains réseaux de neurones profonds appelés « Machines de Boltzmann ». Pour les autres, je laisse toute latitude à votre curiosité.

Voilà j’ai résumé les parties du livre qui me semblaient les plus intéressantes, cependant si vous souhaitez approfondir vos connaissances sachez que le glossaire qui accompagne ce livre à la fin est immensément riche et vulgarise des termes et concepts mathématiques compliqués. Je vous recommande encore une fois d’acheter ces deux livres qui sont des perles de savoir.